Vor zwei Jahren war das noch anders mit KI Fotos. Da reichte ein Blick auf die Hände, und man wusste Bescheid. Sechs Finger hier, verschmolzene Knöchel dort. KI-Bilder hatten diesen charakteristischen Look, dieses "Irgendwas stimmt hier nicht"-Gefühl. Die Augen wirkten manchmal wie tot, die Gesichter zu symmetrisch. Die Beleuchtung fast immer zu perfekt. Man konnte es erkennen, wenn man wusste, worauf man achten musste.

Diese Zeit ist vorbei.

Die Entwicklung ist in den letzten Monaten verstörend schnell gegangen. Midjourney, Stable Diffusion, DALL-E, sie alle haben gelernt. Und zwar nicht nur ein bisschen besser zu werden, sondern fundamental anders zu arbeiten. Was früher die verräterischen Merkmale waren, ist heute Geschichte.

Nehmen wir die Frequenzanalyse. Echte Fotos haben eine charakteristische Energieverteilung im Frequenzspektrum, hauptsächlich im Niedrigfrequenzbereich, weiche Übergänge, organische Strukturen. Frühe KI-Generatoren produzierten flache Kurven mit extremen Peaks im Hochfrequenzbereich, ein klares Muster. Moderne KI-Modelle imitieren diese natürlichen Frequenzverteilungen enorm gut.

Oder Kanten. Baumäste, Haare, die Struktur von Strickpullovern, das waren die Achillesfersen der KI. Die Übergänge wirkten unnatürlich, zu uniform oder zu chaotisch. Jetzt beherrscht die KI komplexe Kantenverläufe. Einzelne Härchen mit unterschiedlichen Lichtreflexen, natürliche Unregelmäßigkeiten, alles da.

Die Symmetrie-Falle funktioniert auch nicht mehr. KI Generatoren lieben Symmetrie. Natürliche Fotos weisen typischerweise unter 15 Prozent Symmetrie auf (unser Gesicht ist eben nicht perfekt spiegelbildlich), während KI-Bilder oft bei über 50 Prozent lagen. Aber die neuesten Modelle integrieren gezielt Asymmetrien, kleine Abweichungen, die ein Bild lebendiger machen.

Texturen waren lange Zeit ein Problem. Fell über größere Flächen? Fehlanzeige. Holzmaserung? Sah aus wie Plastik. Die Algorithmen verglichen benachbarte Bildblöcke und suchten nach abrupten Texturwechseln oder zu homogenen Bereichen. Mittlerweile beherrschen die Generatoren komplexe Texturen problemlos.

Dann gab es noch die Grid-Artefakte. Viele Modelle arbeiteten blockweise, 8x8 oder 16x16 Pixel, was zu subtilen Wiederholungsmustern führte. Besonders beim starken Verkleinern oder Vergrößern, konnte man so ein KI Bild entlarven. Auch das ist nicht mehr so.

Genau wie die unnatürliche Glätte. KI-Bilder hatten oft diese zu perfekten Übergänge, diese unrealistisch glatten Flächen, während echte Fotos natürliches Sensorrauschen aufweisen. Die Rausch-Analyse war ein verlässliches Werkzeug. Moderne Generatoren fügen jedoch gezielt realistisches Rauschen hinzu, mit der richtigen lokalen Varianz, der richtigen Körnung.

Diese Muster sind bei KI-generierten Bildern verschwunden. Und nun?

Die Hersteller geben an, sie würden Wasserzeichen einbauen. Stable Diffusion hat seine Stable Signature, kryptographische Marker im Frequenzbereich. Google DeepMind hat SynthID entwickelt, Wasserzeichen, die selbst nach Kompression bestehen bleiben sollen. Klingt großartig. Nur sind diese Wasserzeichen ohne die spezifischen Decoder der jeweiligen Modelle nicht auslesbar. Die Technologie existiert, aber sie ist nicht öffentlich zugänglich. Und somit nutzlos für jeden, der ein Bild auf seine Herkunft prüfen will.

Dann gibt es noch C2PA, die Coalition for Content Provenance and Authenticity. Adobe, Microsoft und andere haben diesen Standard entwickelt, der Herkunftsinformationen und Bearbeitungshistorie in Metadaten speichern soll. Bilder können explizit als "trainedAlgorithmicMedia" markiert werden. Ist C2PA die Lösung? Stand heute nutzen nur Adobe Firefly und Microsoft Designer den Standard konsequent. Die Liste der Nicht-Implementierer ist deutlich länger als die der Befürworter.

Was bleibt also?

Professionelle, kostenpflichtige Erkennungstools wie Hive AI oder Optic AI nutzen trainierte neuronale Netzwerke, gefüttert mit Millionen von Bildern. Ihre Erfolgsquote soll bei 80 bis 90 Prozent liegen. Was nach viel klingt, bedeutet in der Praxis: Jedes fünfte bis zehnte Bild wird falsch eingeschätzt.

Bitte Gehirn einschalten!

Wir sind zurück beim Ausgangspunkt: menschlicher Verstand. Kritisches Hinterfragen. Ungewöhnlich perfekte Details, unmögliche Perspektiven und vor allem logische Fehler. Das sind die letzten Hinweise.

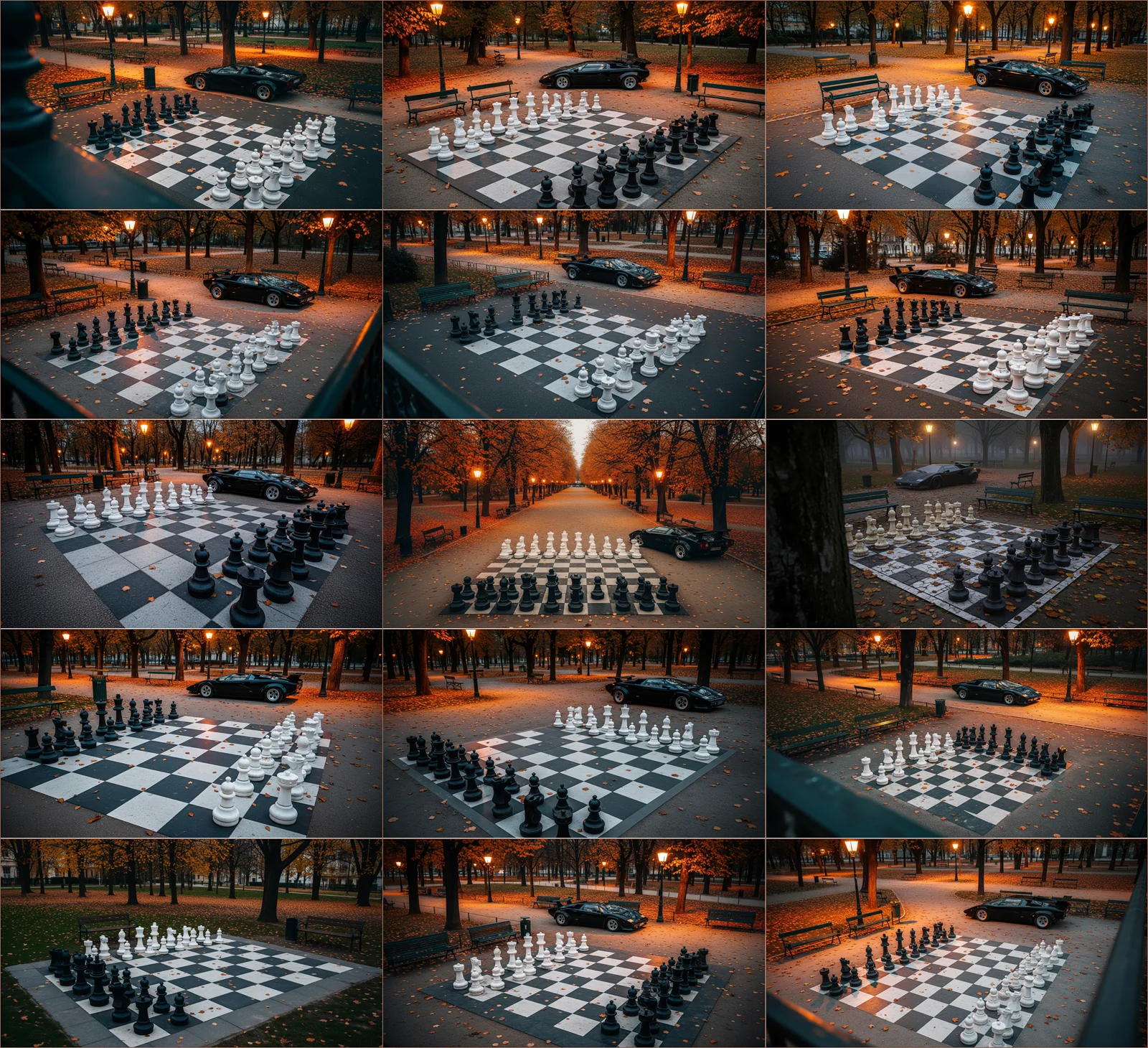

Und dass in der Mitte zwei Könige stehen — Figuren, die in dieser Konstellation nicht hingehören? Der flotte Dreier, den die KI hier produziert hat, entlarvt das Bild.

Mein Fazit

Für uns Fotografen bedeutet das, dass unsere Arbeit nicht mehr automatisch den Realitätsstempel trägt. Dass wir erklären müssen, dass unser Foto echt ist. Dass Skepsis die neue Normalität geworden ist.

P.S. Aber wenn ich daran zurückdenke, wie absurd vor zwei Jahren generierte Autos aussahen. In obigem Motiv, das nur 18 Sekunden zur Erstellung bei einer 2K Auflösung brauchte, sieht der Lambo aus, als wäre ich echt damit zum Schachbrett im Park gefahren. Ach ne, der Park existiert ja gar nicht in echt.

Und wenn ich im Park zum nächsten Schachbrett fahre, hat auch dieses wieder fälschlicherweise 9 Felder pro Reihe, obwohl ich auf den Fehler hingewiesen hatte. Selbst das simple Prinzip "abwechselnd schwarz und weiß" überforderte die KI. Was die Sturheit angeht, ist sie jedenfalls absolut menschlich.

Ich bin wirklich beeindruckt, dass die alten Muster weg sind und die KI-Bilder ziemlich echt wirken. Aber die Logik-Fehler bleiben aktuell noch vorhanden. Auch nach mehr als 15 Anläufen: